În dezvoltare: smartphone-uri care pot evalua starea de spirit

Programul nu analizează ceea ce spune o persoană, ci mai degrabă cum.

„De fapt, am folosit înregistrări ale actorilor care citeau data lunii - chiar nu contează ce spun ei, ci cum ne spun că ne interesează”, a spus Wendi Heinzelman, dr., Profesor de inginerie electrică și informatică.

Programul analizează 12 caracteristici ale vorbirii, cum ar fi tonul și volumul, pentru a identifica una dintre cele șase emoții dintr-o înregistrare sonoră. Cercetătorii spun că atinge o precizie de 81%, o îmbunătățire semnificativă față de studiile anterioare care au atins doar aproximativ 55% precizie.

Cercetarea a fost deja utilizată pentru a dezvolta un prototip de aplicație care afișează fie o față fericită, fie tristă după ce înregistrează și analizează vocea utilizatorului. A fost construit de unul dintre studenții absolvenți ai lui Heinzelman, Na Yang, în timpul unui stagiu de vară la Microsoft Research.

„Cercetarea este încă la început”, a recunoscut Heinzelman, „dar este ușor să imaginați o aplicație mai complexă care ar putea folosi această tehnologie pentru orice, de la ajustarea culorilor afișate pe telefonul mobil (telefon) până la redarea muzicii potrivite Te simți după ce ți-ai înregistrat vocea. ”

Heinzelman și echipa ei colaborează cu doctorii psihologi din Rochester. Melissa Sturge-Apple și Patrick Davies, care studiază în prezent interacțiunile dintre adolescenți și părinții lor. „O modalitate fiabilă de clasificare a emoțiilor ar putea fi foarte utilă în cercetarea noastră”, a spus Sturge-Apple. „Ar însemna că un cercetător nu trebuie să asculte conversațiile și să introducă manual emoția diferitelor persoane în diferite etape.”

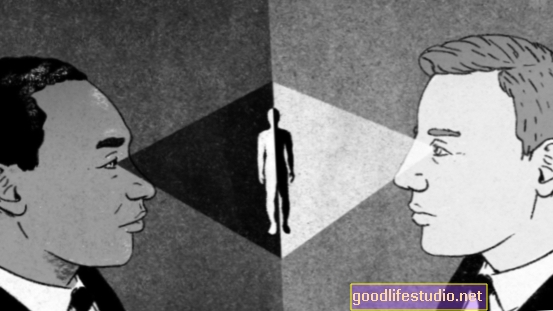

Învățarea unui computer să înțeleagă emoțiile începe cu recunoașterea modului în care oamenii o fac, potrivit cercetătorilor.

„S-ar putea să auziți pe cineva vorbind și să creadă„ oh, sună supărat. ”Dar ce anume te face să crezi asta?” a spus Sturge-Apple.

Ea a explicat că emoția afectează modul în care oamenii vorbesc modificând volumul, tonul și chiar armonicile vorbirii lor. „Nu acordăm atenție acestor caracteristici în mod individual, ci doar am aflat cum sună supăratul - în special pentru oamenii pe care îi cunoaștem”, a adăugat ea.

Dar pentru ca un computer să clasifice emoția, trebuie să lucreze cu cantități măsurabile. Astfel, cercetătorii au stabilit 12 caracteristici specifice în vorbire, care au fost măsurate în fiecare înregistrare la intervale scurte. Cercetătorii au clasificat apoi fiecare dintre înregistrări și le-au folosit pentru a preda programului de computer ce sună „trist”, „fericit”, „înfricoșat”, „dezgustat” sau „neutru”.

Sistemul a analizat apoi noi înregistrări și a încercat să stabilească dacă vocea din înregistrare înfățișează vreo emoție cunoscută. Dacă programul de computer nu a putut decide între două sau mai multe emoții, a lăsat înregistrarea neclasificată.

„Vrem să fim încrezători că atunci când computerul consideră că vorbirea înregistrată reflectă o anumită emoție, este foarte probabil că este într-adevăr portretizând această emoție”, a spus Heinzelman.

Cercetările anterioare au arătat că sistemele de clasificare a emoțiilor sunt foarte dependente de vorbitor, ceea ce înseamnă că funcționează mult mai bine dacă sistemul este antrenat de aceeași voce pe care o va analiza. „Acest lucru nu este ideal pentru o situație în care doriți să puteți realiza doar un experiment pe un grup de oameni care vorbesc și interacționează, cum ar fi părinții și adolescenții cu care lucrăm”, a spus Sturge-Apple.

Noile rezultate confirmă această constatare. Dacă clasificarea emoțiilor bazate pe vorbire este utilizată pe o voce diferită de cea care a antrenat sistemul, precizia a scăzut de la 81 la sută la aproximativ 30 la sută. Cercetătorii se uită acum la modalități de minimizare a acestui efect prin antrenarea sistemului cu o voce din aceeași grupă de vârstă și de același sex.

„Există încă provocări de rezolvat dacă vrem să folosim acest sistem într-un mediu care seamănă cu o situație din viața reală, dar știm că algoritmul pe care l-am dezvoltat este mai eficient decât încercările anterioare”, a spus Heinzelman.

Sursa: Universitatea din Rochester